20 Jahre Auto-Tune: Das Öl, die Cher und der Heartbeat

Seltsamerweise stellt man sich auch im digitalen Zeitalter unter einem Musikinstrument immer noch etwas vor, was man anfassen kann. Dabei war das wichtigste neue Musikinstrument der vergangenen 20 Jahre eine Software. Über die Entstehungsgeschichte und den Wandel vom „Cher-Effekt“ Auto-Tune.

Dies hier wird gerne immer wieder vergessen: Eigentlich geht es darum, mit der Auto-Tune-Technik Tonhöhen-Verfehlungen im Gesang unmerklich zu korrigieren – jedenfalls wenn man sie so einsetzt wie ursprünglich empfohlen. Stellt man die Software allerdings so scharf ein, dass die schiefen Töne nicht mehr sanft auf Höhe gezogen werden, sondern ruckartig, dann entsteht dieser digitale Jodel-Effekt, der klingt, als wäre die Stimme in Plastikfolie eingepackt und würde gerade eine Treppe hoch oder runter purzeln.

Zum ersten Mal hörte man diesen Effekt in Chers Riesenhit „Believe“. Auto-Tune hätte sich kaum einen passenderen Popstar für sein Coming-out aussuchen können. Denn Cher war damals schon der wandelnde Photoshop-Effekt – eine Frau, die sämtliche Unebenheiten und Fehlerchen an sich hat glätten lassen und daraus nie ein großes Geheimnis machte. Dass sie nun auch ihre Stimme manipulieren ließ und dies ebenso offensiv ausstellte, sollte eigentlich niemanden überraschen. „Believe“ wurde am 19. Oktober 1998 veröffentlicht. Weswegen der Auto-Tune-Effekt – oder eben: der „Cher-Effekt“ – nun seinen 20. Geburtstag feiert.

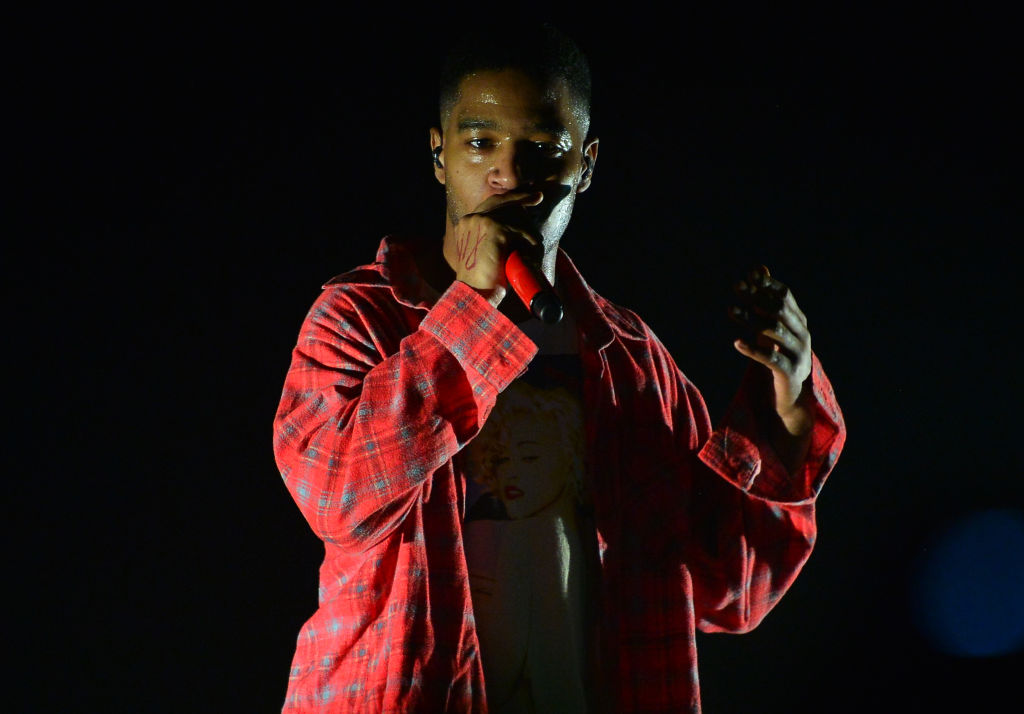

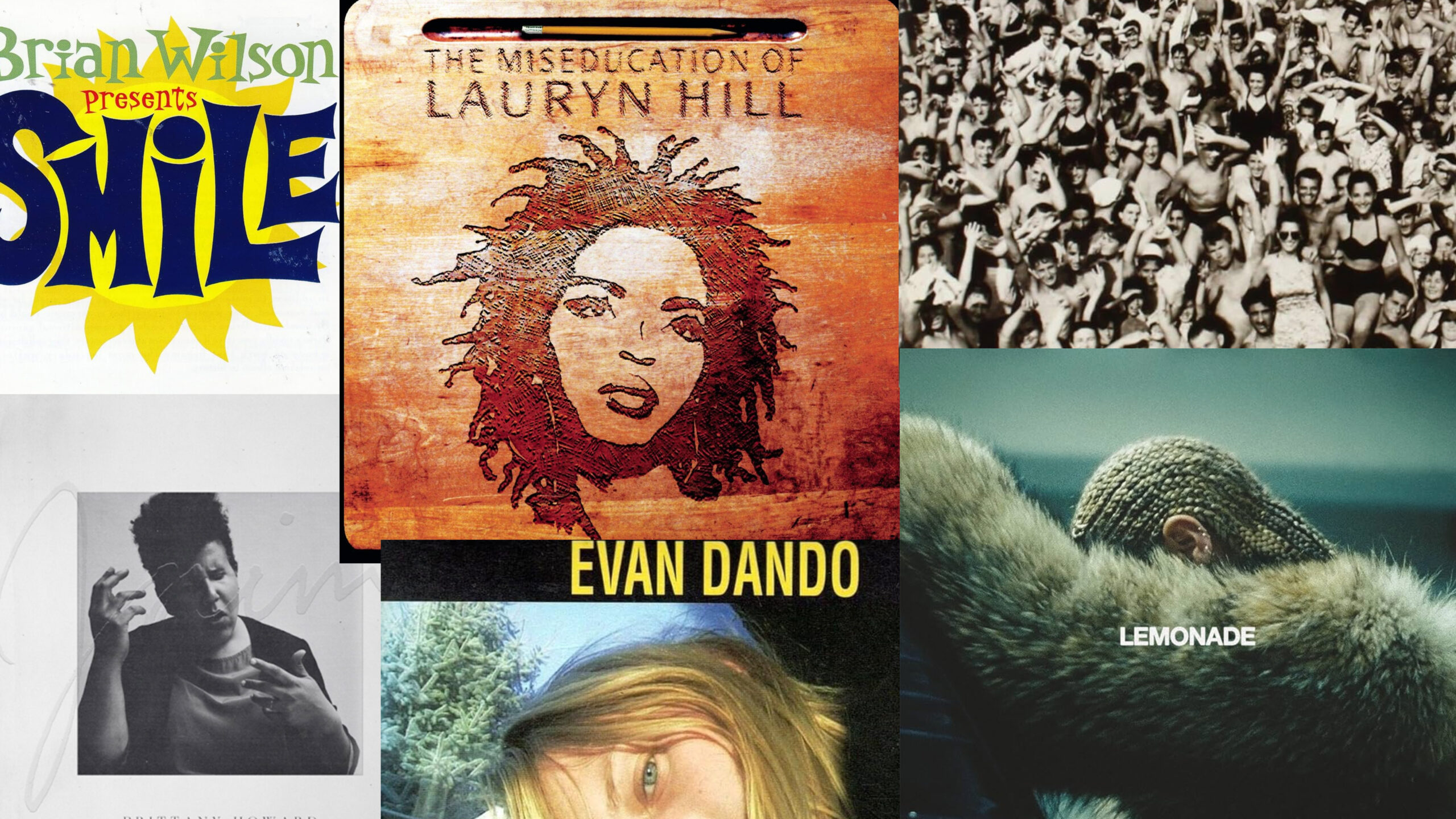

Und was waren das für 20 Jahre! Progressive Folk-Musiker wie Bon Iver lernten die Freuden des digitalisierten Singens kennen; Rapper lernten dank Auto-Tune überhaupt erst das Singen. Beziehungsweise entwickelte sich im Rap mithilfe der Software eine völlig neue Zwischenform aus Sprechgesang, wie man ihn schon kannte, und Gesang im klassischen Sinn. Melodiös waren Raps ja immer schon, auch wenn man ihre Melodien nicht unbedingt so einfach in die Linien des klassischen Notationssystems hätte eintragen können.

Mit Auto-Tune änderte sich das, ab Mitte der Nullerjahre. Fast wirkte es so, als wollten Rapper nicht nur etwas Neues ausprobieren, sondern mit der Software auch betonen, wie musikalisch ihr Sprechgesang ohnehin schon immer gewesen war – nachzuhören bei T-Pain, Kanye West, Future, Yung Hurn und so weiter.

Wobei es auch Widerstand gegen Auto-Tune gab. Der sah allerdings ziemlich alt aus, oder: maskulinistisch – man denke an Jay-Z und seinen Track „D.O.A. (Death of Auto-Tune)“ von 2009. Echte Kerle singen nicht! Oder so. Glaubwürdig war Jay-Zs Protest sowieso nicht: Als Chef von Roc-A-Fella Records, wo Kanye Wests Auto-Tune-Album 808s & HEARTBREAK erschienen war, hatte er ja auch schon gut an dem Effekt verdient.

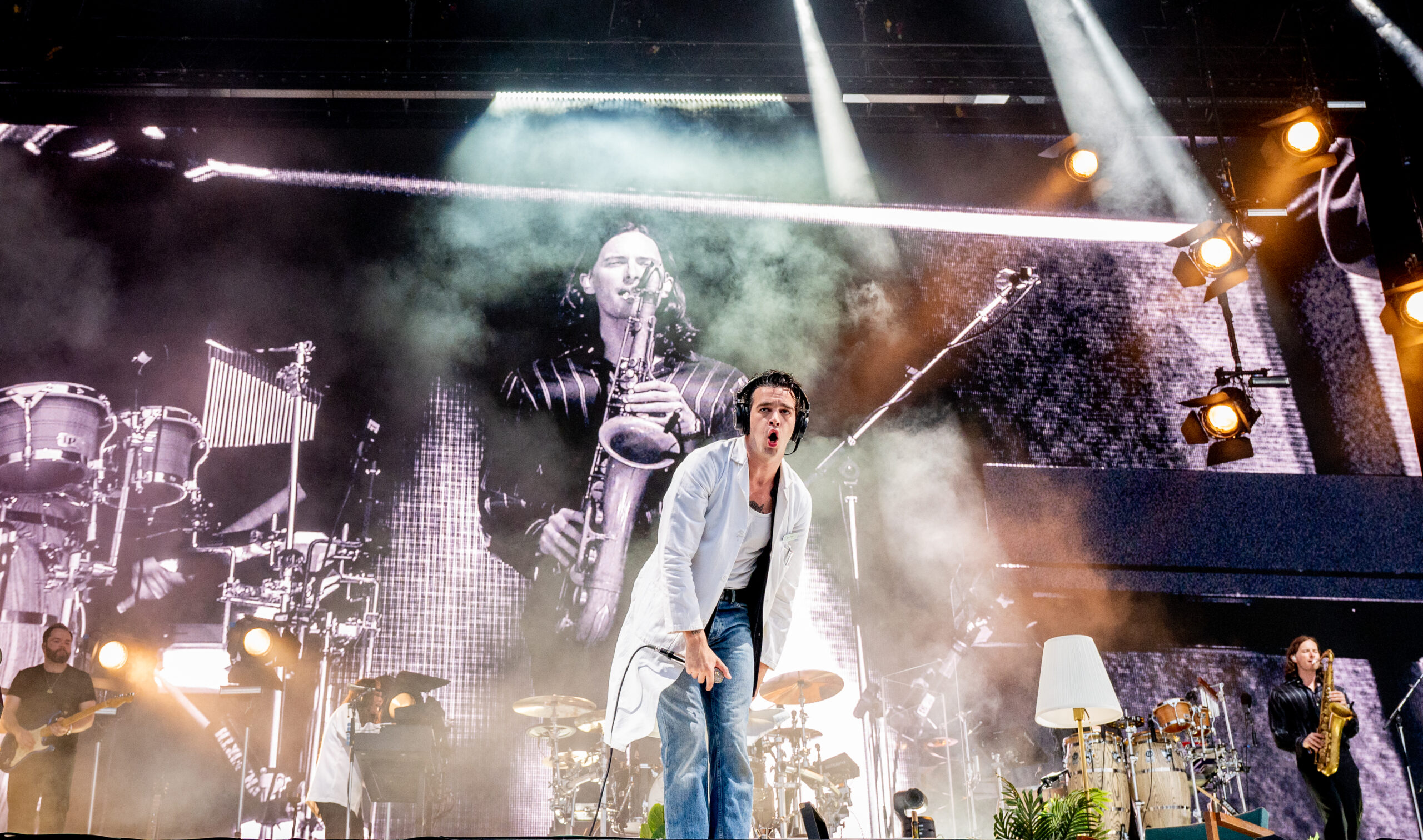

Egal ob Auto-Tune heute hörbar (als Stilmittel und somit als Instrument) oder unhörbar (als „heimliches“ Korrekturwerkzeug) eingesetzt wird: Sicher ist, dass es eingesetzt wird. Nahezu überall. Sogar eine Aretha Franklin bekam diese Behandlung: In ihrer Coverversion von Adeles „Rolling In The Deep“ von 2014 ist der Effekt nicht zu überhören. Nur sagten die Produzenten des Songs ihr anscheinend nicht Bescheid. Als Franklin im selben Jahr vom „Wall Street Journal“ auf Auto-Tune angesprochen wurde, sagte sie, die mächtigste Stimme des Soul: „Oh bitte, das ist doch lächerlich! Ich weiß ja nicht einmal, was dieses Auto-Tune ist.“

Kurz: Niemand geht heute mehr davon aus, dass er oder sie in einer Pop-Produktion oder bei einem Livekonzert eine komplett Auto-Tune-freie Stimme zu hören bekommt. Mit der Folge, dass man umso faszinierter ist, wenn man vielleicht doch noch einmal eine schiefe, nicht ganz so treffsichere, „nackte“ Stimme hört. Vielleicht erklärt sich darüber auch ein Stück weit der Erfolg eines Formats wie „Carpool Karaoke“ auf YouTube. Hier, in diesem SUV neben James Corden, sind die Tonhöhen der Stars noch einmal so zu hören, wie man sie sonst heute eben nicht mehr hört: so wie sie aus dem Mund kommen – nahezu perfekt (Christina Aguilera, Paul McCartney, Sia), eher daneben (Madonna) oder irgendwo dazwischen (Ariana Grande).

Auto-Tune-Erfinder: „Ich habe nur das Auto gebaut, aber ich bin nicht der Geisterfahrer, der damit auf der falschen Straßenseite fährt“

Faszinierend bleibt bis heute die Entstehungsgeschichte von Auto-Tune: Andy Hildebrand heißt der Gründer der US-Firma Antares Audio, die die Software im Frühjahr 1997 auf den Markt brachte. Hildebrand ist Elektroingenieur mit einem Doktor in Signalverarbeitung. Zuvor hatte er für den Ölkonzern Exxon gearbeitet und dort Ende der 70er-Jahre eine Technik zur computerisierten Auswertung seismischer Daten entwickelt. Sie funktioniert so: Auf der Suche nach neuen Ölquellen bringt man Sprengköpfe in der Erde zum Detonieren, die Explosion hallt durch den Boden, man zeichnet die seismischen Reflexionen auf und analysiert sie dann mithilfe des Algorithmus auf Hinweise, wo sich Öldepots befinden könnten. Das klappte wohl recht verlässlich.

Angeregt durch seine Frau kam Hildebrand, selbst Hobbymusiker, um 1990 herum dann auf die Idee, dass sich dieselbe Technologie ja auch dazu eignen könnte, die Tonhöhen in Audiodateien zu analysieren und zu modifizieren. Einmal digitalisiert, unterscheidet sich Gesang im Prinzip nicht groß von seismischen Reflexionen. Das Ziel war allerdings nicht der Cher-Effekt sondern eben die vielen kleinen Korrekturen, die die Stimme perfekt erscheinen lassen. „Ich habe nur das Auto gebaut, aber ich bin nicht der Geisterfahrer, der damit auf der falschen Straßenseite fährt“, sagte Hildebrand im Interview.

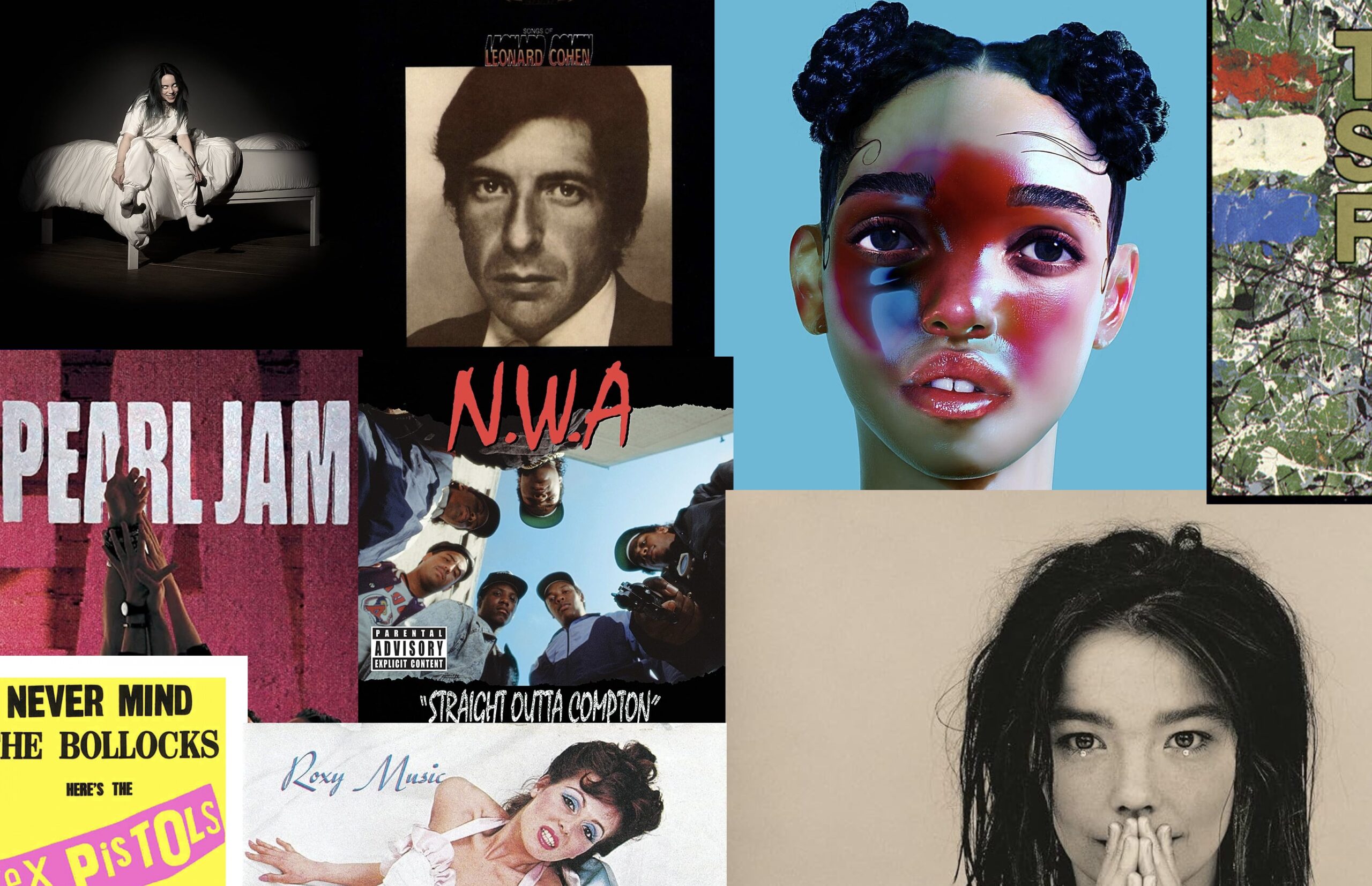

So betrachtet, ist die Sache mit dem Auto-Tune eine ganz klassische Pop-Erfolgsgeschichte – in der oft der Missbrauch von Instrumenten einen neuen Sound oder gar ein ganzes Genre in Gang setzte. Die Entwickler des Roland-Synthesizers TB-303 in Japan zum Beispiel wollten nichts anderes als „normale“ Bass-Sounds emulieren. Dass man ihr Gerät auch dazu benutzen könnte, Dance-Tracks zum giftigen Zwitschern zu bringen, und dass damit Acid-House begründet werden würde, stand ganz bestimmt nicht auf ihrem Plan. Oder die E-Gitarre: Dass sich aus ihren schrillen Verzerrungen eine eigene Ästhetik und letztlich die Rockmusik als solches entwickeln würde, war nicht die Absicht des Erfinders des elektrischen Tonabnehmers.

Allein deswegen müsste man den Auto-Tune-Effekt schon lieben. Wobei das vielleicht schwerer fällt, wenn man weiß, dass er eben auf einer Software aus der Ölindustrie basiert. Eine Software, die dort Öl aus dem Boden zaubert, wo man es sonst vielleicht nie gefunden hätte, zieht inzwischen seit 20 Jahren eine Brillanz aus menschlichen Stimmen heraus, über die diese ohne Hilfe meist nicht verfügen würden.

Im Grunde ist dieser Andy Hildebrand sowieso ein Menschenfreund: In einem Interview für CNN sprach er 2015 darüber, dass er sich – nach Öl und Gesang – als Nächstes mit seinem Algorithmus noch einem ganz neuen Thema widmen wolle: der Verbesserung von Herzschrittmachern und der Verlängerung des Lebens. Implantierte Kardioverter-Defibrillatoren überwachen heute schon die Herzfrequenz ihrer Träger und Trägerinnen auf Unregelmäßigkeiten und geben einen Stromstoß ab, wenn es nötig ist. „Das Problem ist nur, dass die Software manchmal den Herzschlag nicht richtig erkennt. Wir hoffen, dass wir dafür eine Lösung finden“, erklärte Hildebrand in dem Interview.

„Do you beliiiieeeeve in love after love?“ Ja, und daraus, aus einem menschlichen Herzen noch mehr Leben zu holen – dank Algorithmus. Aber hoffentlich ruckelt und purzelt er diesmal nicht.

[facebooklikebox titletext=’Folgt uns auf Facebook!‘]